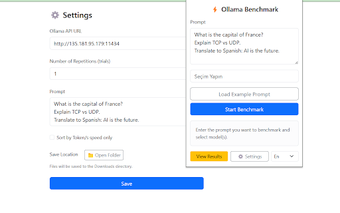

Comparativa de LLMs con Ollama Benchmark

Ollama Benchmark es una extensión de Chrome diseñada para evaluar y comparar el rendimiento de modelos de lenguaje grande (LLMs) como Mistral, LLaMA y Qwen. Esta herramienta permite realizar pruebas de rendimiento basadas en prompts, facilitando el análisis de métricas clave como el conteo de tokens, el tiempo de respuesta y la velocidad de procesamiento. Los usuarios pueden seleccionar uno o más modelos para comparar simultáneamente, lo que optimiza los flujos de trabajo de inteligencia artificial de manera efectiva.

Entre sus características destacan la capacidad de exportar resultados en formatos como .txt, .csv y .json, así como el almacenamiento local de configuraciones y resultados. La interfaz es multilingüe, soportando inglés y turco, y es completamente gratuita. Importante mencionar que no se recopilan datos, ya que todo el procesamiento se realiza en el navegador del usuario.